如何实现多个爬虫循环顺序爬取

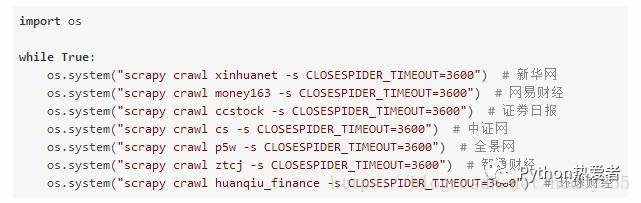

首先设置一个循环,接着为每一个爬虫设置一个定时器,让每一个爬虫爬虫一段时间,再运行下一个爬虫即可。具体代码如下,此处设置每一个爬虫运行3600秒

scrapy采集数据时暂停和恢复采集的方法

http://www.sharejs.com/codes/python/8808

同时运行多个scrapy爬虫的几种方法

https://www.cnblogs.com/skying555/p/5296312.html

最后

以上就是自信发带最近收集整理的关于Scrapy如何实现多个爬虫循环顺序爬取的全部内容,更多相关Scrapy如何实现多个爬虫循环顺序爬取内容请搜索靠谱客的其他文章。

本图文内容来源于网友提供,作为学习参考使用,或来自网络收集整理,版权属于原作者所有。

发表评论 取消回复