#在CSDN上写的第一篇文章

##写的代码有很多不合规范

就是一个很简单的静态网页爬虫

比如requests 应使用 try/catch 结构

##有一个问题不知道怎么解决:

当爬取的数据较多时,是否应该逐行写入文件,像下面写的方法会不会占用太多内存?

##还望大家多多指教

因为初版写完之后不小心 ctrl z 没了,ctrl y 也没找回来,再写的时候就懒得写注释了哈哈。

##连接:合肥新开楼盘链家网

import requests

from lxml import etree

import pandas as pd

start_url = 'https://hf.fang.lianjia.com/loupan/nhs1pg{}/'

headers = {'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/79.0.3945.88 Safari/537.36'}

def is0(x):

if len(x) == 0:

return '暂缺'

else:

return x[0]

houses = []

for i in range(1,36):

url = start_url.format(i)

headers['referer'] = url

r = requests.get(url, headers = headers)

tree = etree.HTML(r.text)

house = tree.xpath('/html/body/div[4]/ul[2]/li')

for e in house:

name = is0(e.xpath('div/div[1]/a/text()'))

type_ = is0(e.xpath('div/div[1]/span[1]/text()'))

status = is0(e.xpath('div/div[1]/span[2]/text()'))

loc1 = is0(e.xpath('div/div[2]/span[1]/text()'))

loc2 = is0(e.xpath('div/div[2]/span[2]/text()'))

loc3 = is0(e.xpath('div/div[2]/a/text()'))

area = is0(e.xpath('div/div[3]/span/text()')).strip('建面').strip('㎡')

tags = str(e.xpath('div/div[5]/span/text()')).strip('[').strip(']')

unitP = is0(e.xpath('div/div[6]/div[1]/span[1]/text()'))

totalP = is0(e.xpath('div/div[6]/div[2]/text()')).strip('总价').strip('万/套')

houses.append([name, type_, status, '{}-{}-{}'.format(loc1,loc2,loc3), area, unitP, totalP, tags])

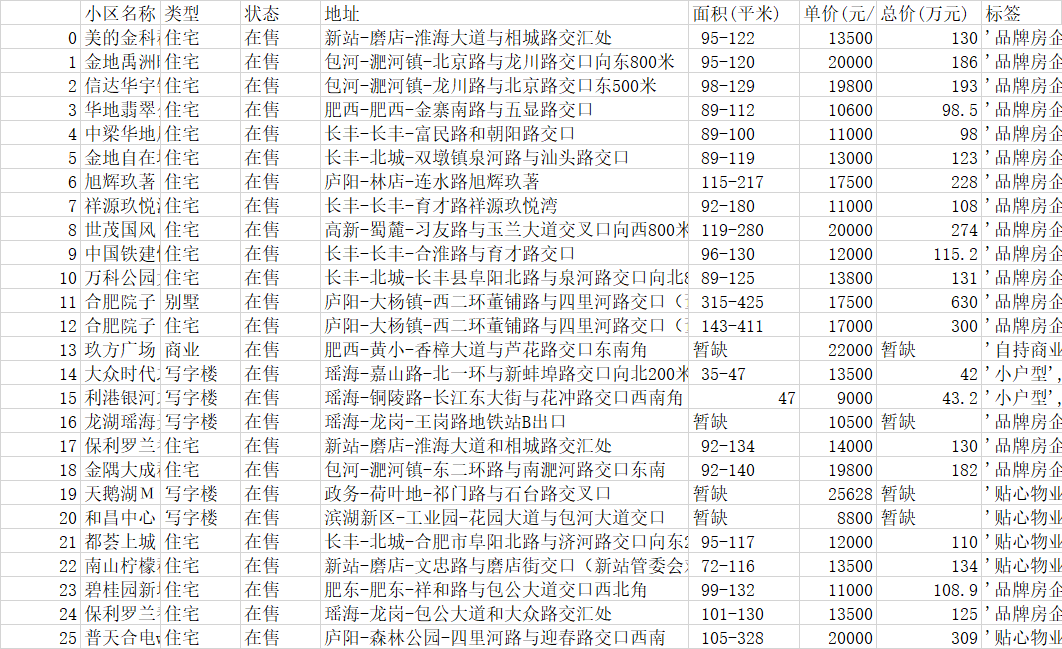

df = pd.DataFrame(houses, columns = ['小区名称', '类型', '状态', '地址', '面积(平米)', '单价(元/平米)', '总价(万元)', '标签'])

df.to_csv('合肥新楼盘.csv', encoding = 'gbk')

得到的结果如下表

另外,本人使用爬虫只为研究技术实现,如有冒犯请告知。

还是希望大家多多指教呀!

最后

以上就是朴素牛排最近收集整理的关于爬虫小白第一篇:利用requests和lxml提取楼盘信息的全部内容,更多相关爬虫小白第一篇内容请搜索靠谱客的其他文章。

本图文内容来源于网友提供,作为学习参考使用,或来自网络收集整理,版权属于原作者所有。

发表评论 取消回复