背景:dataworks提供数据离线批量数据同步。在次离线(批量)的数据通道主要通过定义数据来源和去向的数据源和数据集,提供一套抽象化的数据抽取插件(称之为 Reader)、数据写入插件(称之为 Writer),并基于此框架设计一套简化版的中间数据传输格式,从而达到任意结构化、半结构化数据源之间数据传输的目的。

数据集成的基本步骤如下:

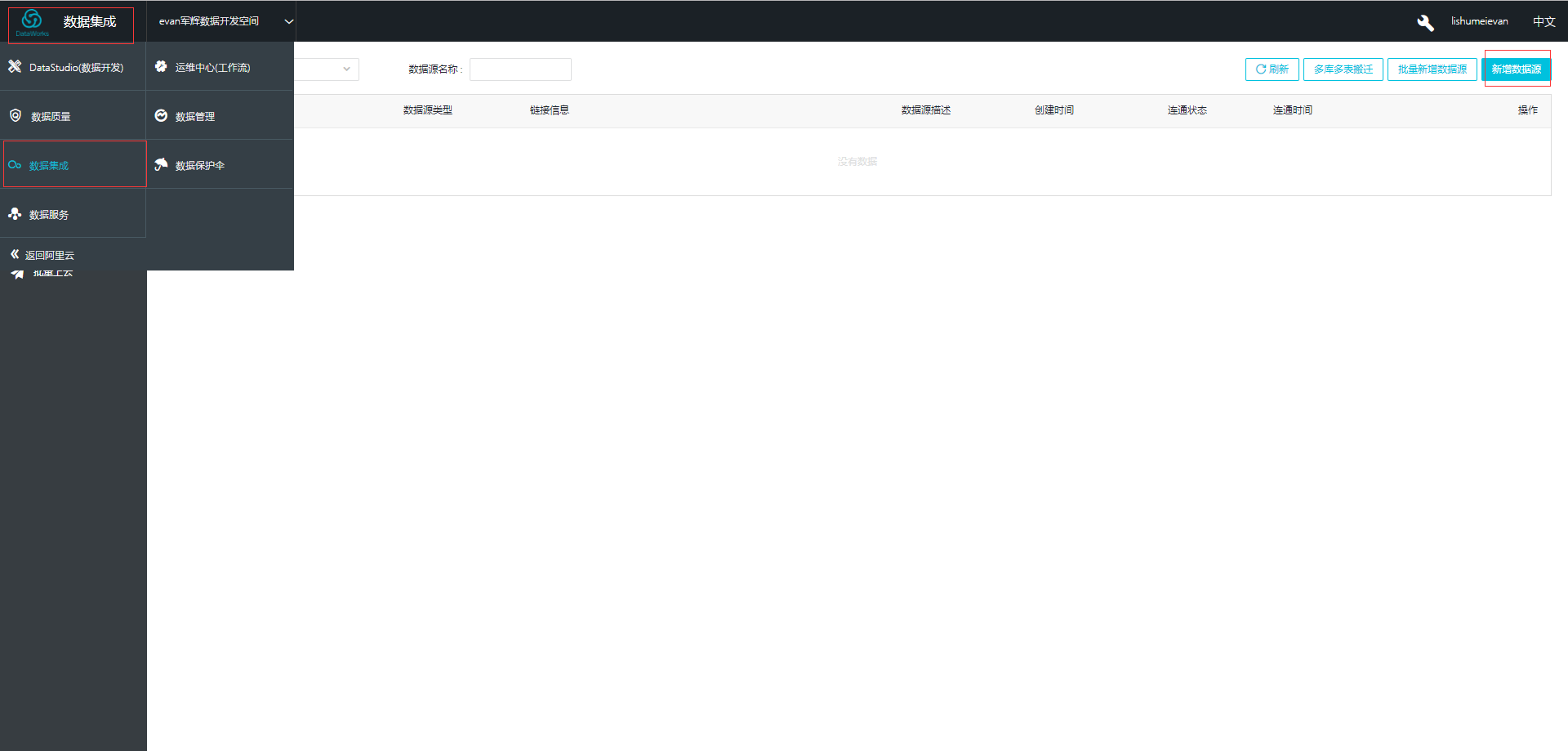

步骤一:点击左上角的LOGO,选择 ‘数据集成’ 模块,点击右上角的新增数据源。

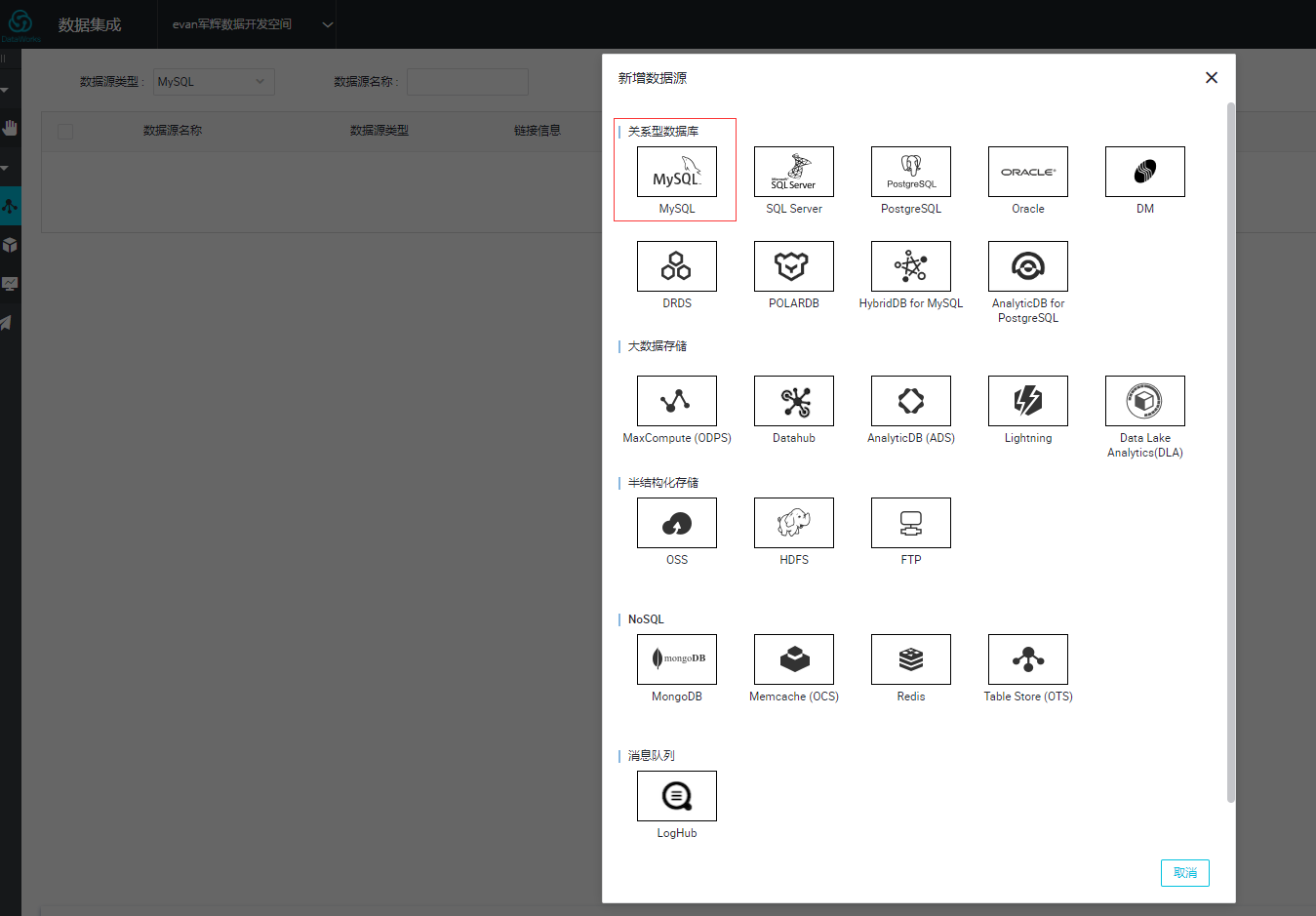

步骤二:根据自己的需求选择需要的数据库连接。

----目前可支持的数据源类型有:

- 文本存储(FTP/SFTP/OSS/多媒体文件等)。

- 数据库(RDS/DRDS/MySQL/PostgreSQL等)。

- NoSQL(Memcache/Redis/MongoDB/HBase等)。

- 大数据(MaxCompute/AnalyticDB/HDFS等)。

- MPP数据库(HybridDB for MySQL等)。

由于每个数据源的配置信息差距较大,需要根据使用情况详细查询参数配置信息。所以在数据源配置、作业配置页面提供了详细描述,请您根据自身情况进行查询使用。---

这里我使用的是 RDS 的MySQL

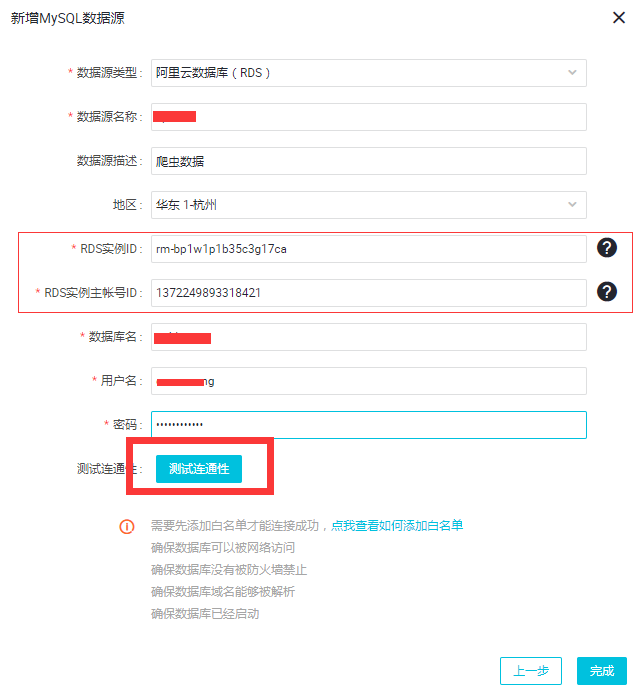

步骤三:填写连接信息。

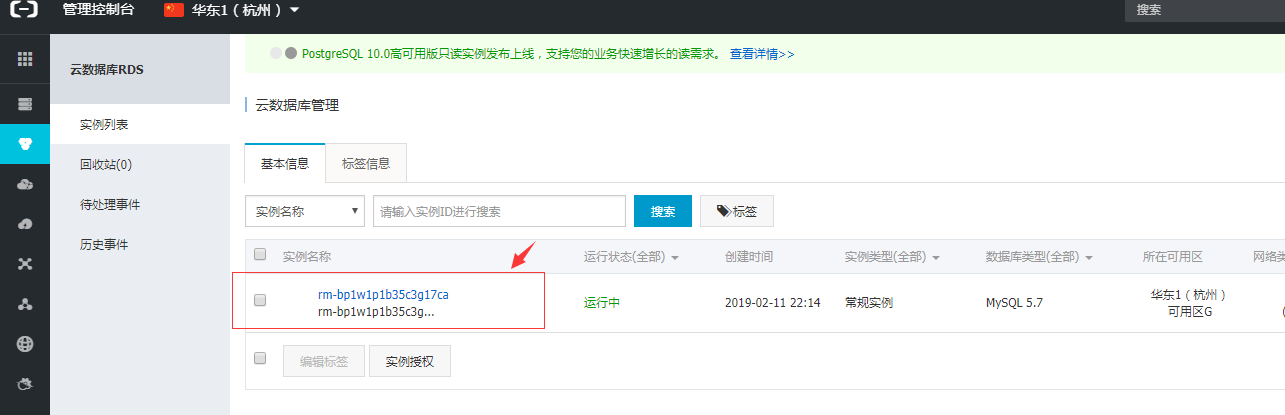

这里的RDS实例的ID是在RDS管理控制台的基本信息页面,如下:

主账ID,要登录控制台,进入安全设置中可以看到实例账号ID,如果你是子账号的话,记得要用主账号。

点击测试连通性。OK成功,点击完成。

结果如下:

步骤四:点击整库迁移批量配置。进入该界面,选择自己需要的同步方式,

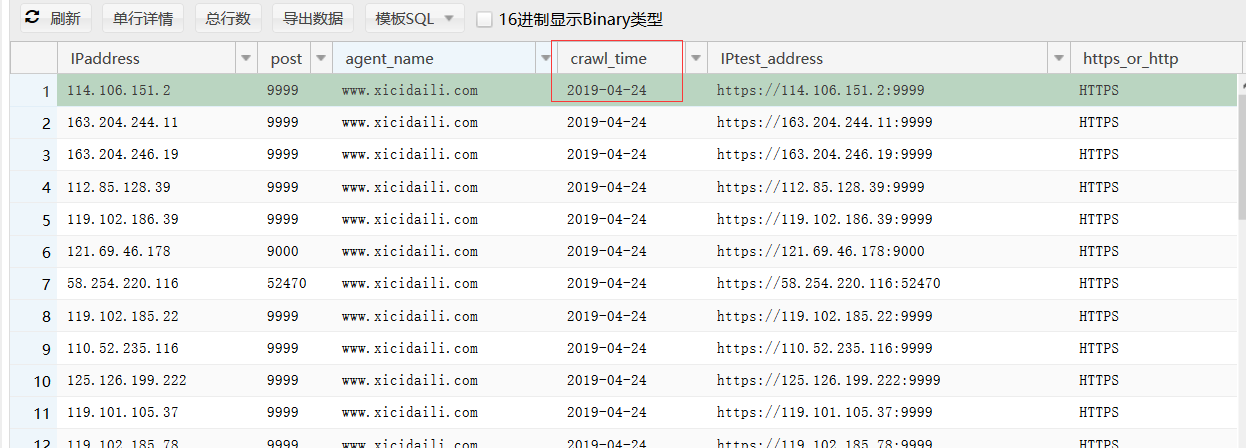

在这我选择每个一小时,增量分批上传库表ipaddress. 由于是选择增量上传,那么dataworks系统会要求一个增量叛变的标准(就是分区的变量,一般是日期),我这边选择的是crawl_time,我爬取下来的IP地址的时间。

点击提交,同步成功。接下里,每天每个小,dataworks会增强同步一次任务。

补充:如果你要求实时秒级别的同步也是OK的同步数据,也是OK的,我这边使用的是DTS的方案。

。之前个做的可视化产品的模板,也是使用这套方案,很好用。

效果如下:

备注:由于数据保密,所以在这里本人写了脚本产生的虚拟的数据。

dataworks的使用地图,宏观上帮助了解大致的框架。

最后

以上就是爱撒娇冰棍最近收集整理的关于商业智能-大数据-后端工作-DATAWORKS(2) 数据集成的步骤和操作/MYSQL 数据离线集成到dataworks(1)的全部内容,更多相关商业智能-大数据-后端工作-DATAWORKS(2)内容请搜索靠谱客的其他文章。

发表评论 取消回复