写的一个生成词云的函数

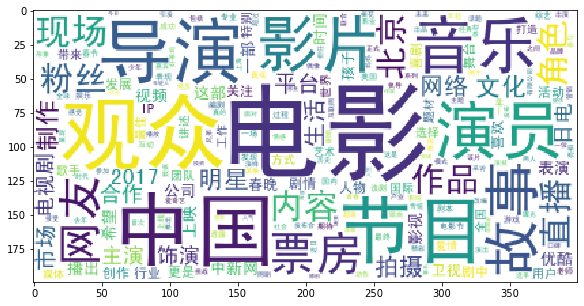

这个是没有自定义图版本

#coding:utf-8

__author__ = '英俊'

import warnings

warnings.filterwarnings("ignore")

#codecs提供的open方法来指定打开的文件的语言编码,它会在读取的时候自动转换为内部unicode

import codecs

#分词包

import jieba

#统计

import pandas as pd

#numpy计算包

import numpy

#可视化

import matplotlib.pyplot as plt

#展示在当前页面中

%matplotlib inline

import matplotlib

#设置大小

matplotlib.rcParams['figure.figsize'] = (10.0, 5.0)

from wordcloud import WordCloud#词云包

def createWordCloud(text_path):

# "./data/entertainment_news.csv"

df = pd.read_csv(text_path, encoding='utf-8')

# 去掉空行

df = df.dropna()

# df.head()

#将数据变成List

content=df.content.values.tolist()

segment=[]

for line in content:

try:

#列表

segs=jieba.lcut(line)

for seg in segs:

#判断是否为空或者是不是换行词

if len(seg)>1 and seg!='rn':

segment.append(seg)

except:

print(line)

continue

words_df=pd.DataFrame({'segment':segment})

# words_df.head()

stopwords=pd.read_csv("data/stopwords.txt",index_col=False,quoting=3,sep="t",names=['stopword'], encoding='utf-8')#quoting=3全不引用

# stopwords.head()

# 先抽取在停用词里面的分词词组,然后再将它去掉

words_df=words_df[~words_df.segment.isin(stopwords.stopword)]

# words_df.head()

# 这一块是个难点,词频统计

words_stat = words_df.groupby('segment').agg(计数=pd.NamedAgg(column='segment', aggfunc='size')).reset_index().sort_values(

by='计数', ascending=False)

# words_stat.head()

# font_path因为中文文本做词云很麻烦,backgrou_color是设置背景底,max是文本的最大大小

wordcloud=WordCloud(font_path="data/simhei.ttf",background_color="white",max_font_size=80)

#这是一个字典生成,x[0]是词是什么,x[1]是词的数量

word_frequence = {x[0]:x[1] for x in words_stat.head(1000).values}

#生成词云

wordcloud=wordcloud.fit_words(word_frequence)

plt.imshow(wordcloud)调用函数

createWordCloud("./data/entertainment_news.csv")生成词云

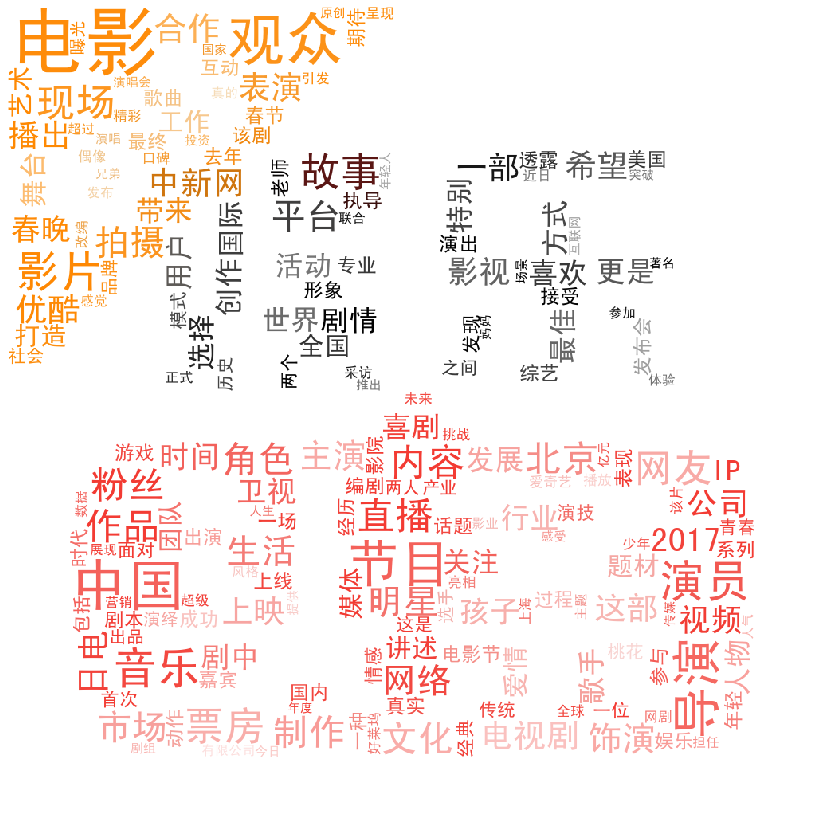

加入自定义图片的

from scipy.misc import imread

#词云大小

matplotlib.rcParams['figure.figsize'] = (15.0, 15.0)

from wordcloud import WordCloud,ImageColorGenerator

def createSuperWordCloud(text_path,image_path):

# "./data/entertainment_news.csv"

df = pd.read_csv(text_path, encoding='utf-8')

# 去掉空行

df = df.dropna()

# df.head()

#将数据变成List

content=df.content.values.tolist()

segment=[]

for line in content:

try:

#列表

segs=jieba.lcut(line)

for seg in segs:

#判断是否为空或者是不是换行词

if len(seg)>1 and seg!='rn':

segment.append(seg)

except:

print(line)

continue

words_df=pd.DataFrame({'segment':segment})

# words_df.head()

stopwords=pd.read_csv("data/stopwords.txt",index_col=False,quoting=3,sep="t",names=['stopword'], encoding='utf-8')#quoting=3全不引用

# stopwords.head()

# 先抽取在停用词里面的分词词组,然后再将它去掉

words_df=words_df[~words_df.segment.isin(stopwords.stopword)]

# words_df.head()

# 这一块是个难点,词频统计

words_stat = words_df.groupby('segment').agg(计数=pd.NamedAgg(column='segment', aggfunc='size')).reset_index().sort_values(

by='计数', ascending=False)

#读取图片生成背景

# 'image/entertainment.jpeg'

bimg=imread(image_path)

# 生成词云

wordcloud=WordCloud(background_color="white",mask=bimg,font_path='data/simhei.ttf',max_font_size=200)

#生成词频

word_frequence = {x[0]:x[1] for x in words_stat.head(1000).values}

wordcloud=wordcloud.fit_words(word_frequence)

# 重新上色

bimgColors=ImageColorGenerator(bimg)

# 去掉off

plt.axis("off")

#重新填写背景

plt.imshow(wordcloud.recolor(color_func=bimgColors))调用函数:

createSuperWordCloud("./data/entertainment_news.csv",'image/entertainment.jpeg')生成词云:

最后

以上就是温暖小刺猬最近收集整理的关于生成词云的函数的全部内容,更多相关生成词云内容请搜索靠谱客的其他文章。

本图文内容来源于网友提供,作为学习参考使用,或来自网络收集整理,版权属于原作者所有。

发表评论 取消回复