解读Graph Attention Multi-Layer Perceptron

- 基本信息

- 摘要

- 实验方法(GAMLP)

- 实验结果

- 数据集

- 结论

- 总结

基本信息

标题:图注意力多层感知器

链接: https://paperswithcode.com/paper/graph-attention-multi-layer-perceptron-1

作者:Wentao Zhang,Ziqi Yin,Zeang Sheng,Yang Li,Wen Ouyang,Xiaosen Li,Yangyu Tao,Zhi Yang,Bin Cui

摘要

问题:图的巨大尺寸和高稀疏性水平阻碍了GNNs在工业场景的应用;在稀疏区域内对节点采用大传播深度时会面临过平滑问题。

方法:图注意力多层感知器(GAMLP)

效果:在具有高扩展性和高效率的同时实现了最先进的性能。

实验方法(GAMLP)

首先,GAMLP分别做了节点自适应的特征传播与标签传播。之后,对传播后得到的特征和标签做加权求和。最后,特征会经过MLP进行非线性变换,我们也会对MLP进行训练。

1.传播

- 我们首先需要进行node-wise的特征传播。和SGC类似,节点可以得到K跳内所有其他节点的特征信息。特征聚合使用的是加权求和的形式,其权重矩阵Wk是一个对角矩阵,矩阵中的第i行第i列的元素值代表节点i在K跳传播后的特征的重要性权重。

- 类似地,我们还会进行node-wise的标签传播。但是值得注意的是,如果我们直接像node-wise特征传播一样直接计算加权融合特征,由于在跳数l较小时传播标签值与原始标签值相近,则简单加权求和会有标签泄漏的问题,导致学习的权重值偏向较小跳数的传播特征。针对这个潜在的问题,我们采用了Last Residual Connection的方法。具体地,第l跳的传播标签特征会加入最后一跳的传播特征,其加权系数与当前跳数有关,且它会随着跳数的增大而减小(使用cos函数)

- 特征聚合

我们提出了两种attention机制:Recursive Attention和JK Attention。前者在计算第l层特征的重要性时拼接了之前所有层的加权特征。这样计算得到的权重值的物理意义为:当前层特征有多少比例是之前所有层所不包含的信息。JK Attention则模仿了JK Net的设计,将每个节点不同层的特征拼接并经过一个MLP进行变换,并将输出特征作为一个reference来衡量当前层的节点特征的重要性。JK Attention得到的权重值的物理意义为:当前层的特征信息相较于所有层的特征信息,其信息量较大的特征占比有多少。 - 模型训练

模型中的MLP部分有两个分支,一部分用于对节点自适应传播特征进行变换,另一部分则对节点自适应传播标签进行变换。最终的输出特征通过β参数进行加权求和,我们可以通过调节β值来控制两者的重要性。如果我们的输入图拥有较好的节点特征,但其标签质量较差,那么我们可以减小β,使得特征更加关注于节点传播特征。模型的目标函数使用交叉熵损失函数。

实验结果

数据集

- 直推式(transductive)学习的设定(11个数据集):三个引文网络数据集(Cora, Citeseer, PubMed),两个用户项目数据集(Amazon Computer, Amazon Photo),两个合著者数据集(Coauthor CS, Coauthor Physics),三个OGB数据集(ogbnproducts, ogbn-papers100M, ogbn-mag),一个腾讯视频图集。

- 归纳式(inductive)学习的设定(3个数据集):PPI, Flickr, and Reddit

结论

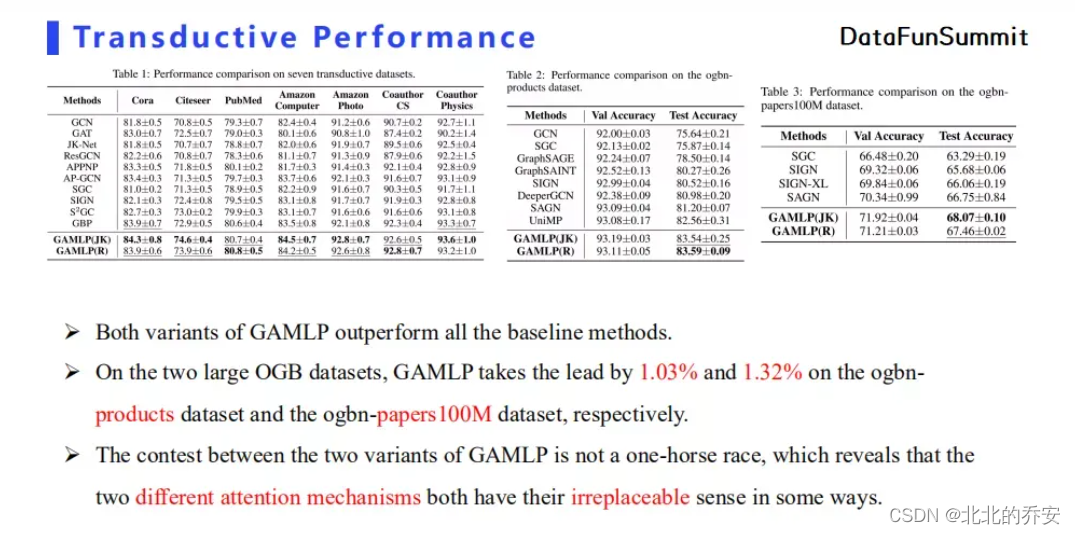

- 在直推式(transductive)学习的设定下,实验表明:

- 两种GAMLP相较于所有基线方法在所有数据七个数据集上都有一定的性能提升。

- 两种attention机制的特征融合方法都是不可被直接替代的,它们各自都有自己的优势。

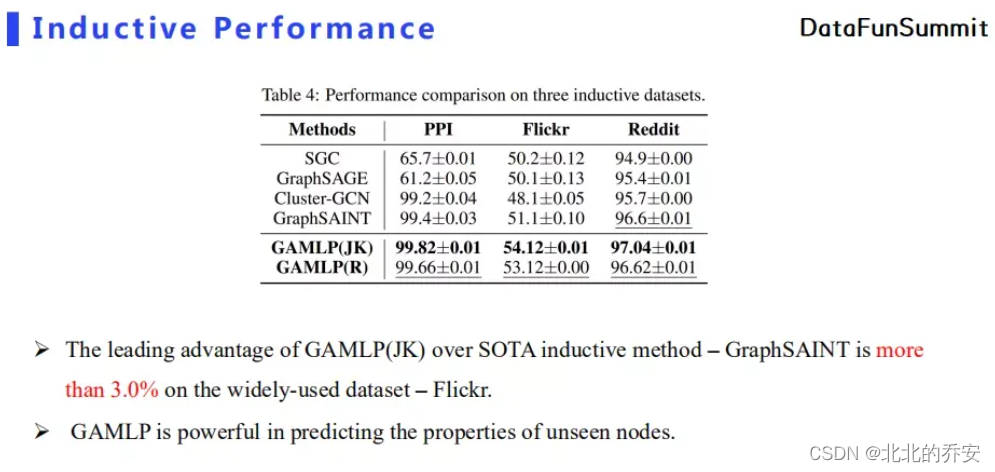

- 在归纳式(inductive)学习的设定下,实验表明:

- GAMLP始终优于所有基线方法,GAMLP可以有效地对未知节点的属性进行预测。

- GAMLP始终优于所有基线方法,GAMLP可以有效地对未知节点的属性进行预测。

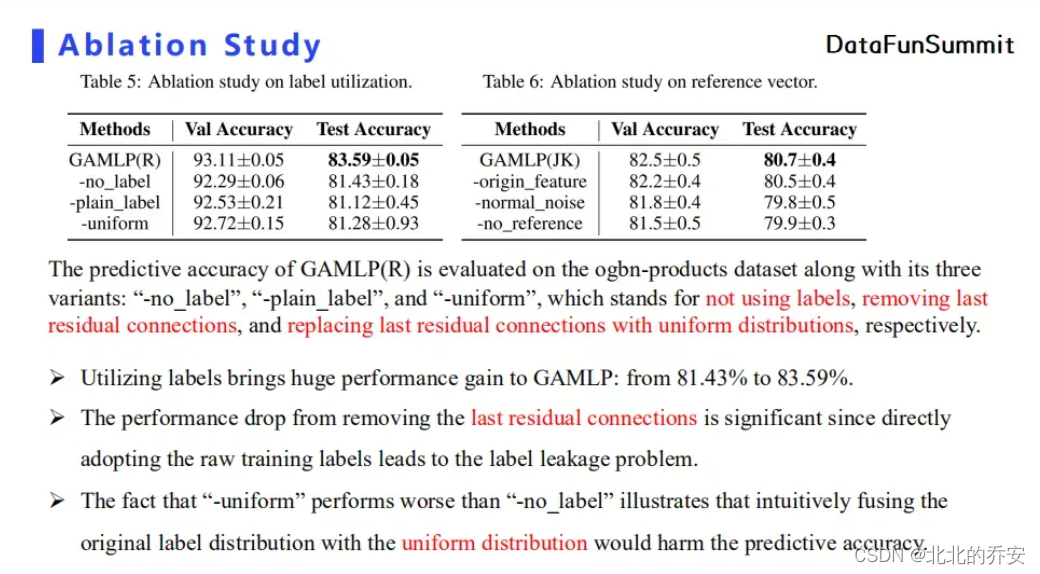

- 这证明了 标签泄漏问题会负面影响模型的预测能力。而加入last residual connection 后模型效果最佳,证明了其在改善标签泄漏问题的重要性。

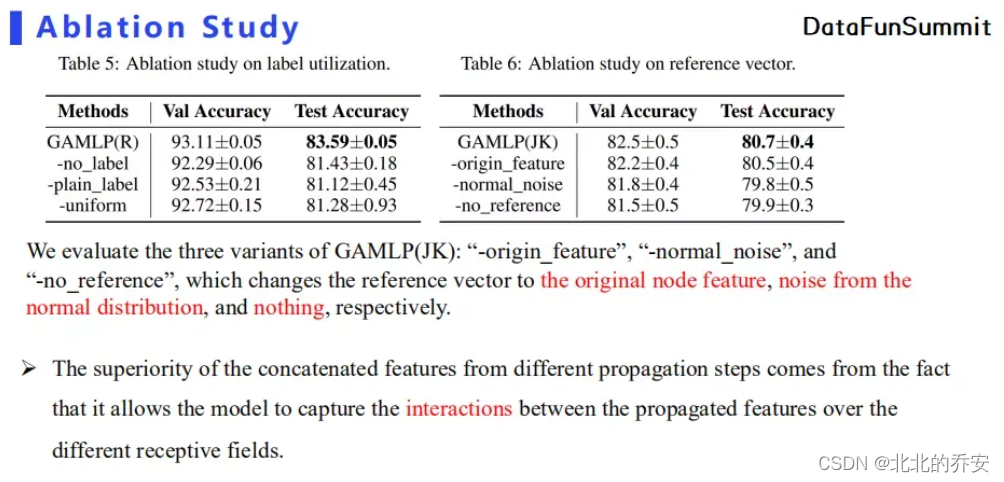

- 实验结果表明后面几种参考向量相比于JK Attention机制,模型性能都有不同程度的下降。

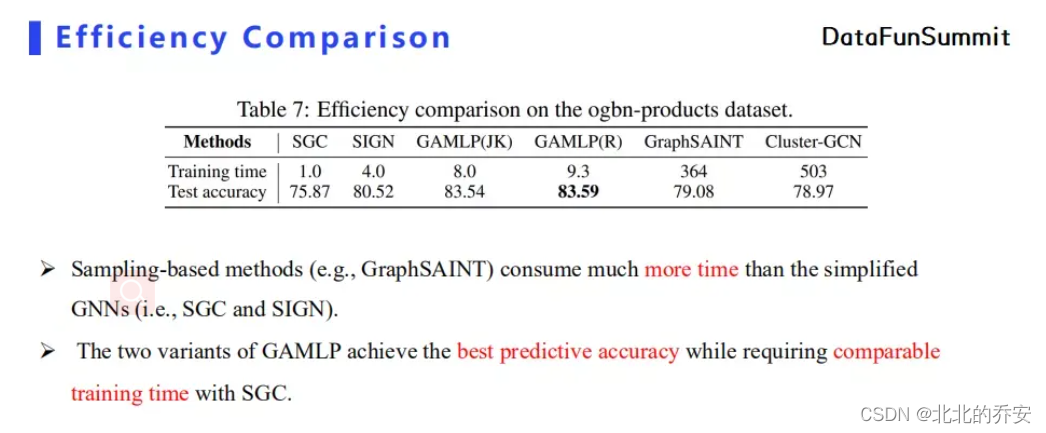

- 针对模型效率我们也进行了对比实验。GAMLP虽然比起SGC和SIGN在单机上要慢一些,但是我们的预测精度比较好,而且训练时间也不会相差太多。相对地,采用图采样的模型比采用解耦思想的模型训练时间要多出不止一个数量级。

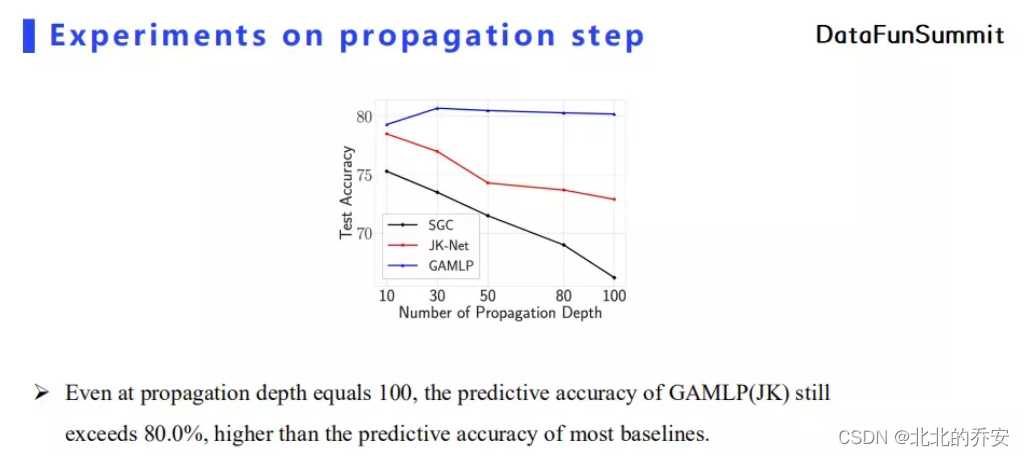

- 我们对传播深度也进行了对比。当传播深度为100时,GAMLP的分类精度依然可以达到80%以上,远超其他基线模型。这在实际应用中会有很大的好处,因为GAMLP不需要针对不同类型的图对模型深度进行调参。

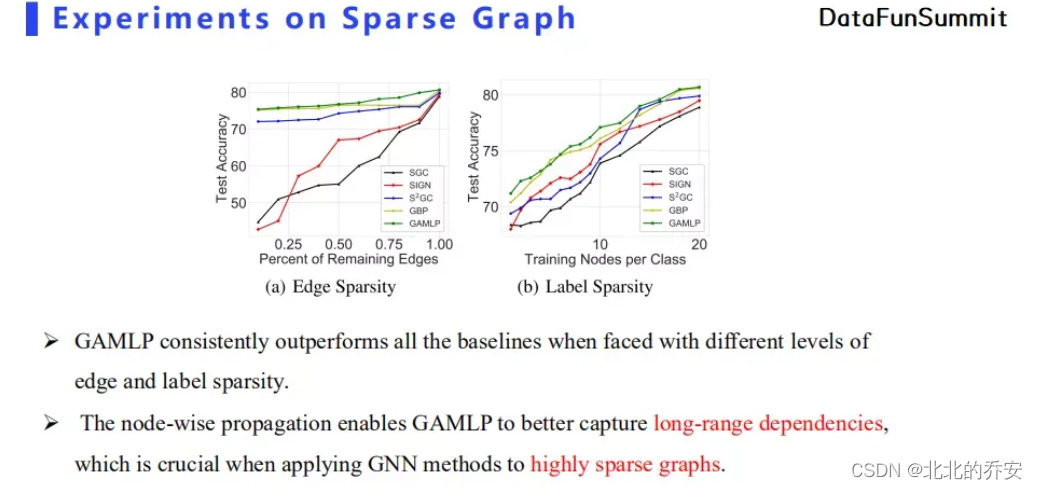

最后,GAMLP在各类型的稀疏图上的性能也比其他基线模型更优,即GAMLP无论在边数比较稀少或者标签值比较缺乏的情况下都能得到较优的分类精度,证明了它可以利用长距离节点特征来增强图表达。

总结

GAMLP在深度、可扩展性,以及计算效率上具有如下优势:

- 它可以达到很深的传播深度,并保证不出现过平滑现象;

- GAMLP无论在单机场景下还是分布式场景下都可以获得较好的加速效果;

- GAMLP计算效率比较高,因为它只需要一次消息传播预处理即可,而模型训练仅仅针对后面的MLP部分,所以训练速度较快。

GAMLP的应用场景有两方面:

- 我们可以将其使用在稀疏图上,因为GAMLP的传播深度可以设定得很深,使得其可以在稀疏图上获得更好的节点表达;

- 由于GAMLP的高效性和高可扩展性,它可以处理超大规模图(包含十亿甚至上百亿节点的图)。

最后

以上就是成就花生最近收集整理的关于图注意力多层感知器基本信息摘要实验方法(GAMLP)实验结果总结的全部内容,更多相关图注意力多层感知器基本信息摘要实验方法(GAMLP)实验结果总结内容请搜索靠谱客的其他文章。

本图文内容来源于网友提供,作为学习参考使用,或来自网络收集整理,版权属于原作者所有。

发表评论 取消回复