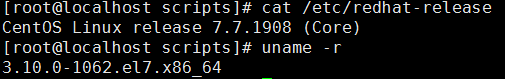

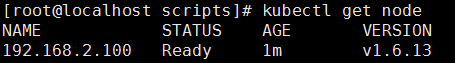

环境:

192.168.2.100 master 和node1

192.168.2.101 node2

docker版本

![]()

k8s版本

master节点安装

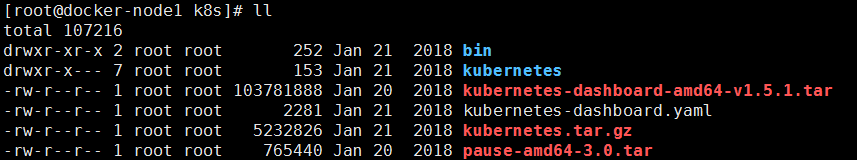

导入两个docker镜像

docker load < pause-amd64-3.0.tar

docker load < kubernetes-dashboard-amd64-v1.5.1.tar

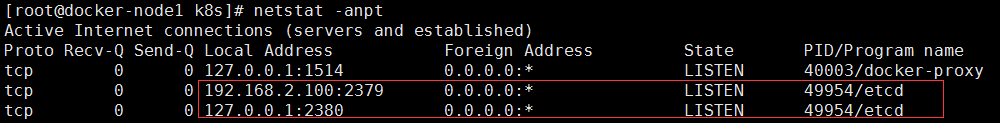

安装etcd

yum -y install etcd

修改etcd配置文件监听地址

vim /etc/etcd/etcd.conf

6 ETCD_LISTEN_CLIENT_URLS="http://192.168.2.100:2379"

21 ETCD_ADVERTISE_CLIENT_URLS="http://192.168.2.100:2379"

systemctl start etcd.service

systemctl enable etcd.service

2379端口 是客户端连接端口

2380端口 是etcd集群连接端口

下载二进制文件的脚本,因为无法访问google所以这里我们是下不下来的

/root/k8s/kubernetes/cluster/get-kube-binaries.sh

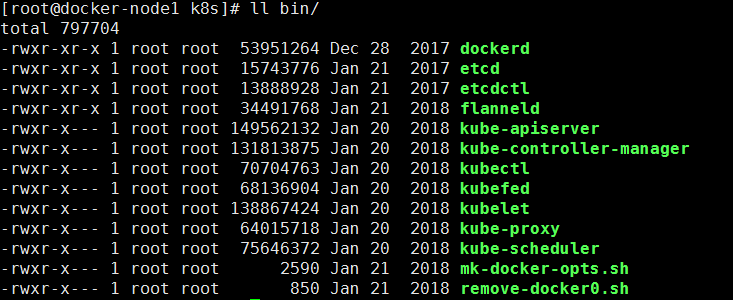

我准备好的所需二进制文件

开始master

tar xf kubernetes.tar.gz

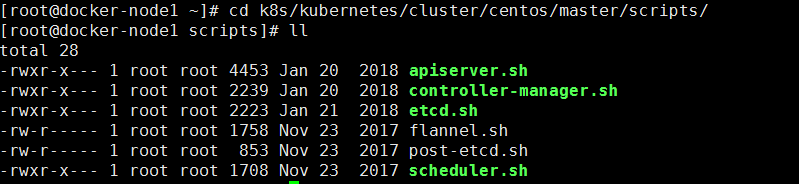

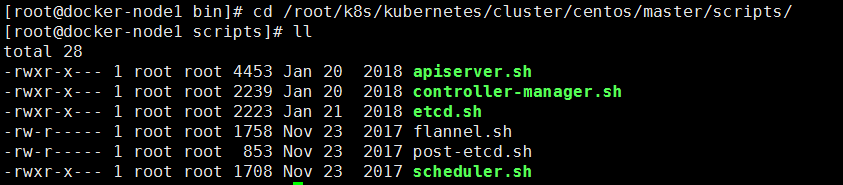

cd k8s/kubernetes/cluster/centos/master/scripts/

首先保证etcd2379端口存在 不然之后都无法操作

创建目录

因为安装脚本中会把配置文件和二进制文件放到指定的目录下面

mkdir -p /opt/kubernetes/{cfg,bin}

把所需要得二进制文件拷贝到指定目录(提前下载好的二进制文件)

cd k8s/bin/

mv * /opt/kubernetes/bin/

到这里我们就安装完了!!!

下面我们要做的就是配置启动服务

1 配置启动kube-apiserver 使用8080端口

cd /root/k8s/kubernetes/cluster/centos/master/scripts/

apiserver.sh其中有四个传参

- MASTER_ADDRESS=${1:-"8.8.8.18"} MASTER地址

- ETCD_SERVERS=${2:-"http://8.8.8.18:2379"} ETCD地址

- SERVICE_CLUSTER_IP_RANGE=${3:-"10.10.10.0/24"} 服务的范围

- ADMISSION_CONTROL=${4:-""} 资源控制列表

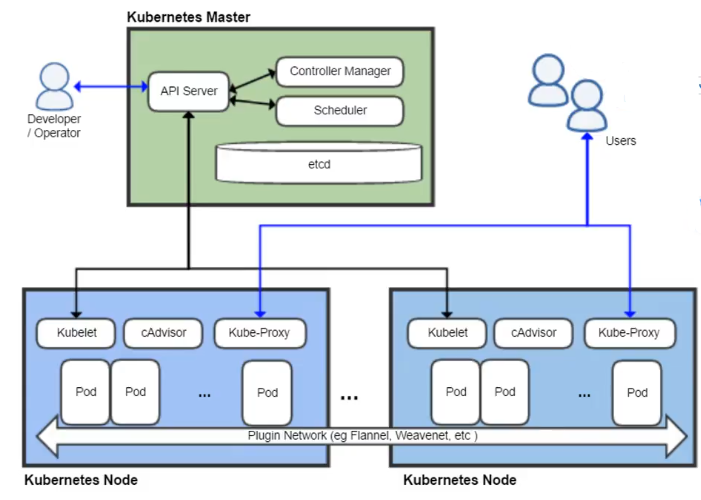

kube-apiserver提供了k8s各类资源对象(pod,RC,Service等)的增删改查及watch等HTTP Rest接口,是整个系统的数据总线和数据中心。

kubernetes API Server的功能:

- 提供了集群管理的REST API接口(包括认证授权、数据校验以及集群状态变更);

- 提供其他模块之间的数据交互和通信的枢纽(其他模块通过API Server查询或修改数据,只有API Server才直接操作etcd);

- 是资源配额控制的入口;

- 拥有完备的集群安全机制.

./apiserver.sh 192.168.2.100 http://192.168.2.100:2379 10.1.0.0/16

![]()

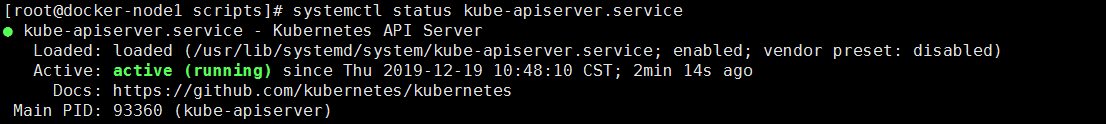

执行后查看kube-apiserver启动状态

systemctl status kube-apiserver.service

这条命令做了什么?

他在/opt/kubernetes/cfg/下创建了kube-apiserver配置文件

创建了/usr/lib/systemd/system/kube-apiserver.service 服务

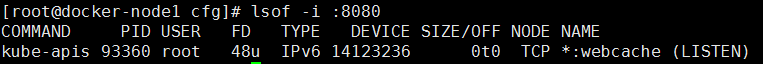

查看端口

lsof -i :8080

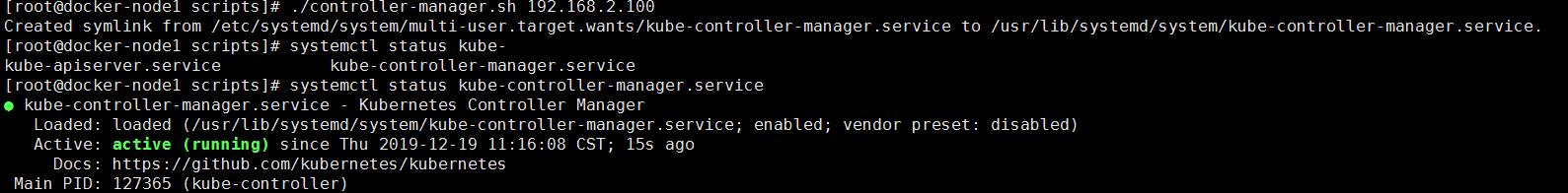

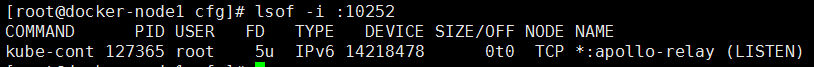

2 配置启动controller-manager复制控制器 使用10252端口

controller-manager.sh 只有一个传参

- MASTER_ADDRESS=${1:-"8.8.8.18"} MASTER地址

./controller-manager.sh 192.168.2.100

查看启动状态

systemctl status kube-controller-manager.service

查看端口

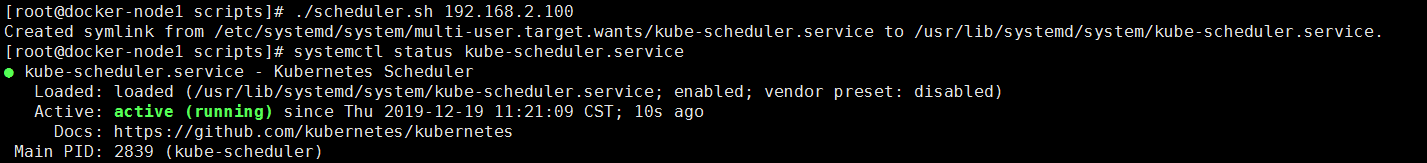

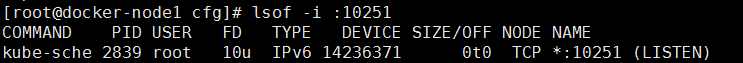

3 配置启动scheduler 调度器 使用10251端口

scheduler.sh 只有一个传参

- MASTER_ADDRESS=${1:-"8.8.8.18"} MASTER地址

./scheduler.sh 192.168.2.100

查看启动状态

systemctl status kube-scheduler.service

查看端口

测试服务

设置环境变量

vim .bash_profile

PATH=$PATH:$HOME/bin:/opt/kubernetes/bin

source .bash_profile

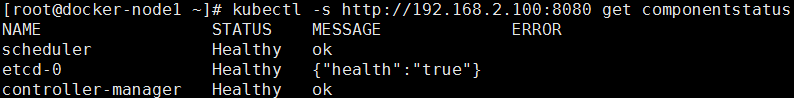

查看组件状态

kubectl -s http://192.168.2.100:8080 get componentstatus

为了以后操作简便 设置个别名

vim .bash_profile

alias kubectl='kubectl -s http://192.168.2.100:8080'

source .bash_profile

到这里MASTER节点部署完毕

部署node节点

docker load < kubernetes-dashboard-amd64-v1.5.1.tar

docker load < pause-amd64-3.0.tar

mkdir -p /opt/kubernetes/{cfg,bin}

mv /root/k8s/bin/* /opt/kubernetes/bin/

tar xf kubernetes.tar.gz

配置安装

1 kubelet

在每个节点(node)上都要运行一个 worker 对容器进行生命周期的管理,这个 worker 程序就是 kubelet。

简单地说,kubelet?的主要功能就是定时从某个地方获取节点上 pod/container 的期望状态(运行什么容器、运行的副本数量、网络或者存储如何配置等等),并调用对应的容器平台接口达到这个状态。

kubelet 除了这个最核心的功能之外,还有很多其他特性:

定时汇报当前节点的状态给 apiserver,以供调度的时候使用

镜像和容器的清理工作,保证节点上镜像不会占满磁盘空间,退出的容器不会占用太多资源

运行 HTTP Server,对外提供节点和 pod 信息,如果在 debug 模式下,还包括调试信息

等等……

kubelet.sh 其中有四个传参

MASTER_ADDRESS=${1:-"8.8.8.18"} MASTER地址

NODE_ADDRESS=${2:-"8.8.8.20"} NODE地址

DNS_SERVER_IP=${3:-"192.168.3.100"}

DNS_DOMAIN=${4:-"cluster.local"}

./kubelet.sh 192.168.2.100 192.168.2.101

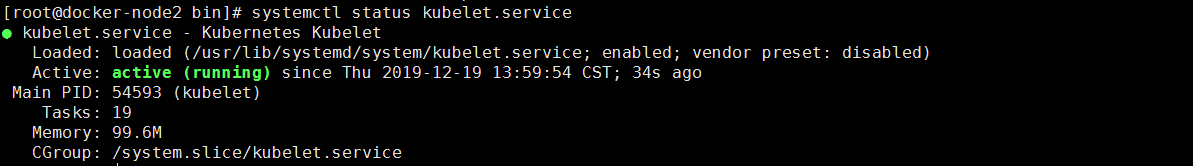

查看状态

systemctl status kubelet.service

2 proxy

在每个节点上运行网络代理。这反映每个节点上 Kubernetes API 中定义的服务,并且可以做简单的 TCP 和 UDP 流转发或在一组后端中轮询,进行 TCP 和 UDP 转发

proxy.sh 其中有两个传参

MASTER_ADDRESS=${1:-"8.8.8.18"}

NODE_ADDRESS=${2:-"8.8.8.20"}

./proxy.sh 192.168.2.100 192.168.2.101

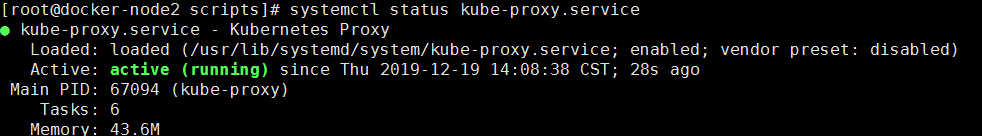

查看状态

systemctl status kube-proxy.service

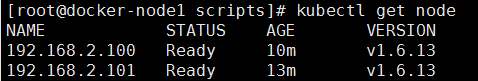

安装完成后再MASTER端验证NODE节点

kubectl get node

网络

Flannel是CoreOS团队针对Kubernetes设计的一个网络规划服务,简单来说,它的功能是让集群中的不同节点主机创建的Docker容器都具有全集群唯一的虚拟IP地址。

默认的Docker配置中,每个节点上的Docker服务会分别负责所在节点容器的IP分配。这样导致的一个问题是,不同节点上容器可能获得相同的内外IP地址。

Flannel的设计目的就是为集群中的所有节点重新规划IP地址的使用规则,从而使得不同节点上的容器能够获得“同属一个内网”且”不重复的”IP地址,并让属于不同节点上的容器能够直接通过内网IP通信。

Flannel实质上是一种“覆盖网络(overlay network)”,也就是将TCP数据包装在另一种网络包里面进行路由转发和通信,目前已经支持UDP、VxLAN、AWS VPC和GCE路由等数据转发方式。

安装配置

已经提前下好了二进制文件和执行脚本,存放路径

/root/k8s/kubernetes/cluster/centos/node/scripts/flannel.sh

/opt/kubernetes/bin/flanneld

flannel.sh

ETCD_SERVERS=${1:-"http://8.8.8.18:2379"} ETCD地址

FLANNEL_NET=${2:-"172.16.0.0/16"} FLANNEL创建的网络

配置启动

./flannel.sh http://192.168.2.100:2379 10.2.0.0/16

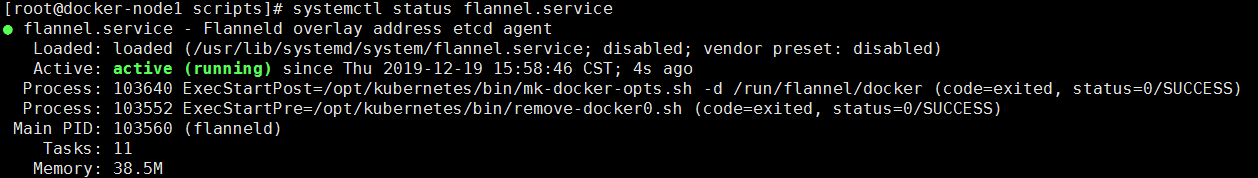

systemctl start flannel.service

systemctl status flannel.service

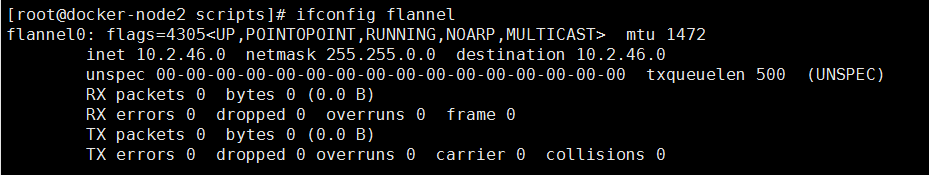

启动后查看网络

ifconfig flannel

配置Docker里使用Flannel网络

因为Docker版本需要修改配置文件

vim /root/k8s/kubernetes/cluster/centos/node/scripts/docker.sh

有些版本不支持overlay存储模式所以如果有报错就删除 -s overlay

DOCKER_OPTS="-H tcp://127.0.0.1:4243 -H unix:///var/run/docker.sock --selinux-enabled=false ${DOCKER_OPTS}"

./docker.sh

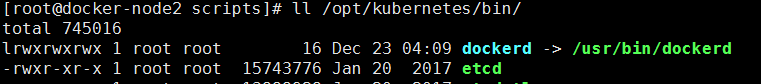

如果执行还是启动不起来,进行如下操作

rm -f /opt/kubernetes/bin/dockerd

ln -s /usr/bin/dockerd /opt/kubernetes/bin/

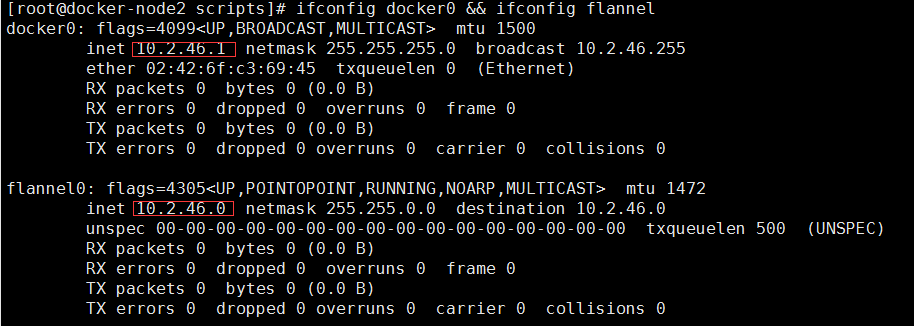

配置完成后查看网络状态

ifconfig docker0 && ifconfig flannel

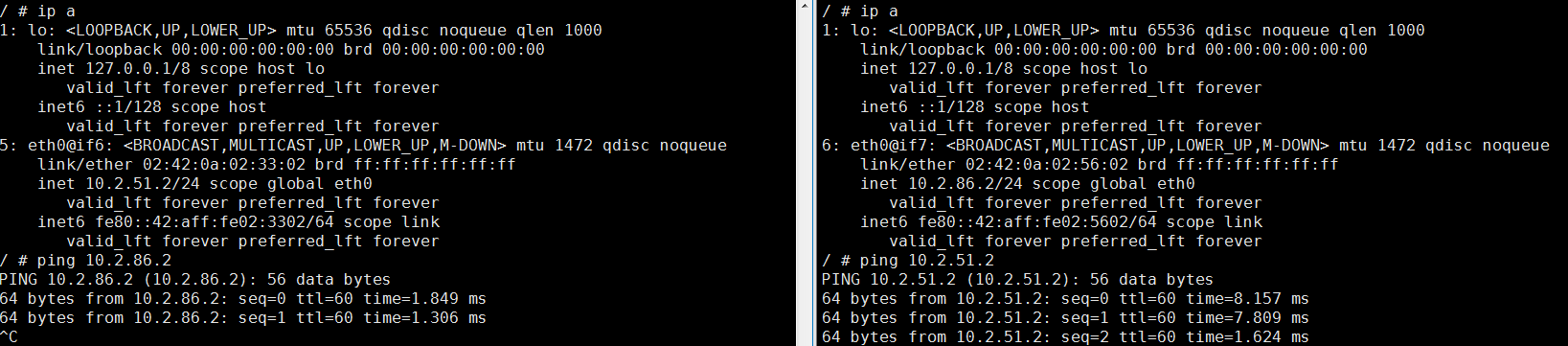

在两个NODE节点上创建容器测试网络

docker run -it --rm --name test1 busybox

最后

以上就是满意太阳最近收集整理的关于Kubernetes集群组件安装(二进制安装)的全部内容,更多相关Kubernetes集群组件安装(二进制安装)内容请搜索靠谱客的其他文章。

发表评论 取消回复