1.立体匹配的关键任务就是预测精准的视差图,对于视差图每一个像素位置的值并不是(0-255)灰度值,而是一个视差值。

2.那么这些视差值如何得到的呢,最开始是由传统方法的 ’argmin‘得到。

- arg min 就是使后面这个式子达到最小值时的变量的取值。

- 例如 函数F(x,y):

arg min F(x,y)就是指当F(x,y)取得最小值时,变量x,y的取值。

3.但这个 'argmin’并不可微,也就是说无法反向传播。

- 所以 GCNet这篇文章提出了’soft argmin’这个函数。

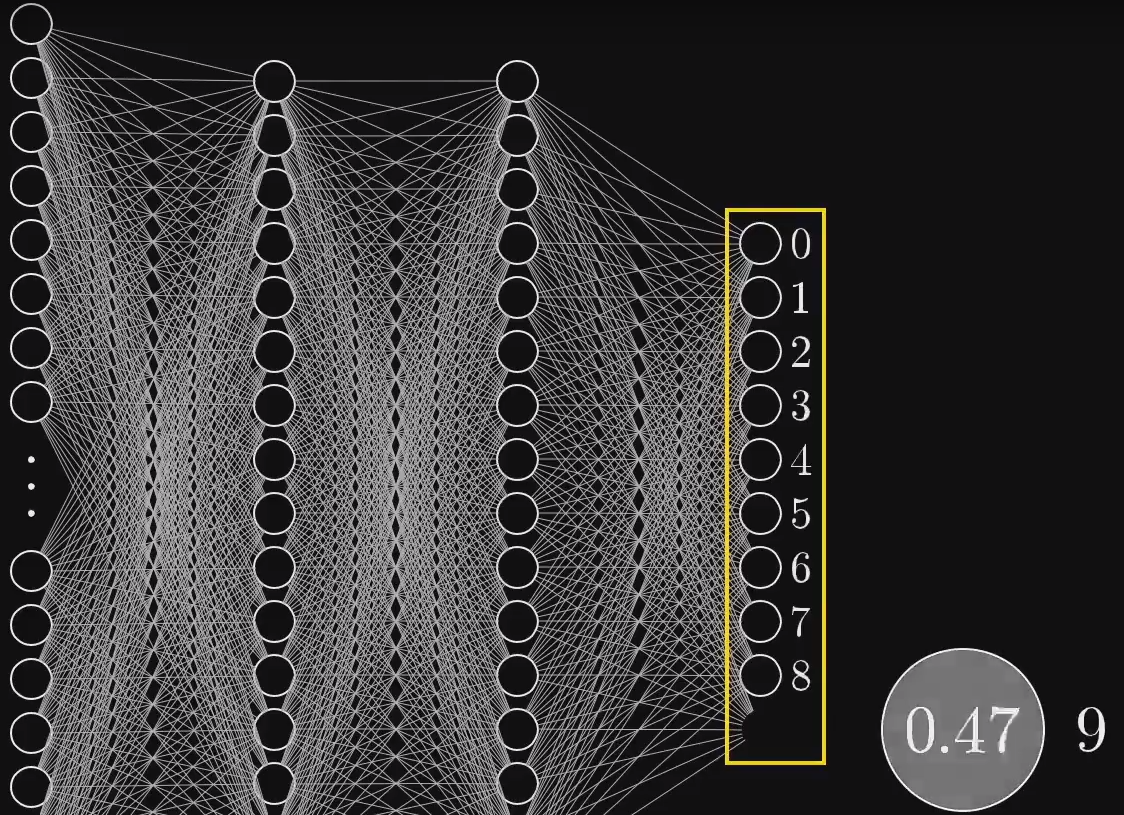

- 这个函数是‘softmax’操作,经常用于cv的分类任务中,将预测值转换为概率。就是最后的fc-layer将每个分类都赋予概率值。

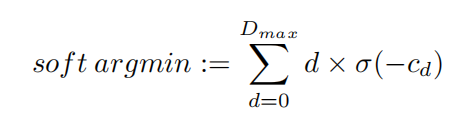

4.那么在立体匹配中 'soft max’这个函数是如何使用的呢?

- 首先大家要清楚 经过代价聚合后的’cost volume’仍然是一个4D的代价体,深度学习的loss都是用自己网络的预测值与GT(Groud True)做对比分析,经过梯度计算对权重进行调整反向传播回每个神经元。

- 所以对于输出维视差图的立体匹配网络,用这个4D的’cost volume’是无法生成loss的,所以要把它压缩到2D(把3D的特征体提取到2D的视差图).

- 这时候采用’soft max’的思想

把经过代价聚合过程的每个视差等级的feature maps通道压缩成1,每个视差等级只有一个feature map,softmax为每个视差等级都计算一个概率,每个像素的视差d乘以改层视差等级的概率,累加得出最后该像素的视差值,从而生成视差图 - 注:‘softmax’ 分配给每个视差等级的概率和为’1’.

soft argmin生成预测的视差图,之后还要经过 loss函数计算,反向传播调整网络。

enjoy~

最后

以上就是奋斗睫毛最近收集整理的关于立体匹配 --视差预测‘soft argmin‘的全部内容,更多相关立体匹配内容请搜索靠谱客的其他文章。

本图文内容来源于网友提供,作为学习参考使用,或来自网络收集整理,版权属于原作者所有。

发表评论 取消回复