我是靠谱客的博主 疯狂战斗机,这篇文章主要介绍[显存被占满,程序无法运行问题]ResourceExhaustedError (see above for traceback): OOM when allocating tensor,现在分享给大家,希望可以做个参考。

最近在实验室的服务器上跑tensorflow程序,一直都没有报错,但是今天却突然报错,而且出错提示显示的内容从未见到过,错误提示如下:

错误提示资源耗尽,无法分配tensor出错。通过在网上查找原因以后才明白,是因为后台存在其他进程占用GPU资源。问题出在两方面,一个是有其他进程正在GPU上运行占用GPU资源,另外一个是由于所写的模型逻辑出了问题,比如分配大小等等。第二种情况需要自己重新检查模型数据和逻辑,一般情况下先考虑第一种情况,第一种情况的解决方案如下:

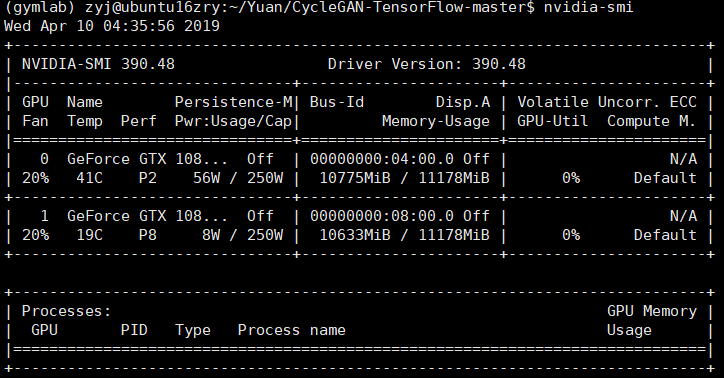

首先在命令行输入 nvidia-smi 显示GPU的使用情况

每个参数的使用情况详见https://blog.csdn.net/Cloudox_/article/details/78651637

主要关心的参数为Memory-Usage,如上图所示,两块GPU的显存都被极大的占用了,但是GPU-Util(GPU利用率为0),那么说明后台有进程在消耗GPU资源。

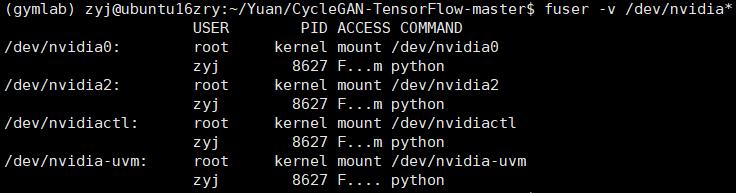

命令行输入 fuser -v /dev/nvidia*,如下图所示就会显示使用GPU的进程:

把消耗资源的进程关闭即可:命令行输入 kill -9 进程号 ,再次显示GPU的使用情况:

至此,问题圆满解决!

最后

以上就是疯狂战斗机最近收集整理的关于[显存被占满,程序无法运行问题]ResourceExhaustedError (see above for traceback): OOM when allocating tensor的全部内容,更多相关[显存被占满,程序无法运行问题]ResourceExhaustedError内容请搜索靠谱客的其他文章。

本图文内容来源于网友提供,作为学习参考使用,或来自网络收集整理,版权属于原作者所有。

![OOM when allocating tensor of shape [] and type float [[node conv2d_224/kernel/Initializer/random_un...](https://file2.kaopuke.com:8081/files_image/reation/bcimg9.png)

![Tensorflow Deep MNIST: Resource exhausted: OOM when allocating tensor with shape[10000,32,28,28]](https://file2.kaopuke.com:8081/files_image/reation/bcimg10.png)

![Mask-RCNN应用 -Training Error: MaskRCNN OOM when allocating tensor with shape[2,512,320,320]](https://file2.kaopuke.com:8081/files_image/reation/bcimg12.png)

![[显存被占满,程序无法运行问题]ResourceExhaustedError (see above for traceback): OOM when allocating tensor](https://file2.kaopuke.com:8081/files_image/reation/bcimg13.png)

![bug6-ResourceExhaustedError: OOM when allocating tensor with shape[512,15,15,128]](https://file2.kaopuke.com:8081/files_image/reation/bcimg14.png)

![OOM when allocating tensor with shape[5184,4,4,2048] and type float on /job:localhost/replica:0/task](https://file2.kaopuke.com:8081/files_image/reation/bcimg1.png)

![tensorflow:OOM when allocating tensor with shape[225,256,256,36] and type float on /job:localhost/re](https://file2.kaopuke.com:8081/files_image/reation/bcimg2.png)

发表评论 取消回复