靠谱客(kaopuke.com)6月10日消息:ModelScope 推出了预训练大语言模型(LLM)推理引擎 DashInfer,支持 C++ 和 Python 语言接口,可在多种 CPU 架构上高效推理大模型。

DashInfer 采用 C++ Runtime 编写,支持连续批处理和多 NUMA 推理,能充分利用服务器级 CPU 的算力,为推理14B 及以下的 LLM 模型提供更多硬件选择。该引擎已开源,提供轻量级架构,高精度实现,优化的计算 Kernel,以及行业标准 LLM 推理技术。DashInfer 支持主流 LLM 开源模型和 PTQ 量化技术。

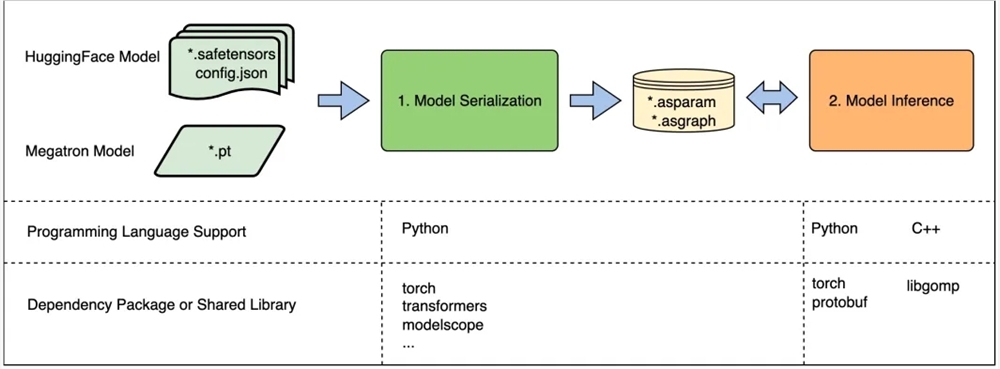

此外,引擎还提供多语言 API 接口,支持多种硬件和数据类型,包括 x86CPU 和 ARMv9CPU,以及 FP32、BF16、InstantQuant 等数据类型。关于模型支持,DashInfer 可以加载和序列化模型,执行推理过程,并采用 DLPack 格式的 tensor 与外部框架交互。在单 NUMA 架构下,推理引擎使用多线程和线程池进行调度;而在多 NUMA 架构下,引擎采用多进程 client-server 架构,实现 tensor parallel 的模型推理。

性能测试结果表明,DashInfer 在 ARM 和 x86CPU 上具有良好的推理性能,能够有效提升大模型推理效率。

代码开源地址:

https://github.com/modelscope/dash-infer

推理体验地址:

https://www.modelscope.cn/studios/modelscope/DashInfer-Demo

(举报)

发表评论取消回复